AWSの機械学習・画像認識サービスであるAmazon Rekognition を試してみたので記録を残しておきます。

今回はまず、画像中の人の顔を検出するタスクをやってみました。

また、例によってPython(boto3)を使っています。

使い方はめちゃくちゃ簡単で、boto3のクライアントAPIから、detect_faces()というメソッドを呼び出すだけでした。

ドキュメントはこちらです。

参照: Rekognition — Boto3 Docs 1.17.93 documentation

対象のデータはローカルのファイルをバイト列のデータとして渡す方法と、S3にアップロードしてそのバケット名とファイル名を渡す方法の2種類があります。

ドキュメントには、

The input image as base64-encoded bytes or an S3 object.

と書いてあるので、Base64エンコードしないといけないのかと思ったのですが、これはどうやらドキュメントの誤りです。

Base64エンコードして渡すと逆にエラーになりますので、バイト列で読み込む時はファイルを読み込んだバイトデータをそのまま渡してください。

(予想ですが、boto3のライブラリが内部処理で Base64エンコードしてくれてると思います。)

せっかくこのブログでもBase64エンコーディングの方法を紹介する記事を書いて準備していたのにいらなかったですね。

引数の渡し方は少し特殊で、名前付き引数に辞書型で渡す必要があります。

ローカルのファイルを使う場合は次のようにします。

ちなみに画像は、AWSのコンソールでサンプルとして表示される家族写真を使います。(ファイル名:family.jpg)

import boto3

# 画像データを読み込む。

with open("./family.jpg", "rb") as f:

img = f.read()

client = boto3.client('rekognition')

response = client.detect_faces(Image={'Bytes': img})

S3にアップロードしたデータを使う場合は次のようにします。

client = boto3.client('rekognition')

response = client.detect_faces(

Image={

'S3Object': {

'Bucket': '{バケット名}',

'Name': 'family.jpg',

}

},

)

結果は、辞書型で帰ってきます。FaceDetailsというキーの中身が、メインの検出結果で、

ResponseMetadataのほうはRequestのIdや、HTTPレスポンスのステータスコード、処理を実行した時刻などのメタデータが入ってます。

print(response.keys())

# dict_keys(['FaceDetails', 'ResponseMetadata'])

response[“FaceDetails”] の中身は配列で、検出された顔一人分ごとに辞書型で検出された情報が入っています。

今回のサンプルでは3人検出されているのですが、全部表示すると長いので一人分お見せすると次のようになります。

(整形のためにjsonライブラリ使います)

import json

print(json.dumps(response["FaceDetails"][0], indent=4))

"""

{

"BoundingBox": {

"Width": 0.1937681883573532,

"Height": 0.3873019516468048,

"Left": 0.2916979193687439,

"Top": 0.13570082187652588

},

"Landmarks": [

{

"Type": "eyeLeft",

"X": 0.34084638953208923,

"Y": 0.2765427529811859

},

{

"Type": "eyeRight",

"X": 0.4209189713001251,

"Y": 0.31195494532585144

},

{

"Type": "mouthLeft",

"X": 0.32429391145706177,

"Y": 0.40175312757492065

},

{

"Type": "mouthRight",

"X": 0.39117804169654846,

"Y": 0.43135175108909607

},

{

"Type": "nose",

"X": 0.3650367856025696,

"Y": 0.3684481084346771

}

],

"Pose": {

"Roll": 17.15113067626953,

"Yaw": -3.947751760482788,

"Pitch": -1.8470479249954224

},

"Quality": {

"Brightness": 62.19182586669922,

"Sharpness": 78.64350128173828

},

"Confidence": 99.99921417236328

}

"""

BoundingBox の中にあるのが、顔が検出された位置です。顔を囲む長方形の情報が含まれています。

Landmarksの下に、目、鼻、口の両端の位置が含まれます。

Poseは顔の向きです。

Qualityは画像の明るさなどの情報で、Confidenceは境界ボックス内に顔が含まれている信頼度になります。

詳しくはこちら

参考: イメージ内の顔を検出する – Amazon Rekognition

顔やそのパーツの位置の座標が0〜1の範囲に収まっていることから分かる通り、これらは

画像の左上を(0%,0%)、右下を(100%, 100%)とした時の相対的な位置を示しています。

上のJSON型データを見てもどのくらい正確に検出できているかわからないと思うので可視化してみましょう。

使い慣れているので、Matplotlibでやってみました。

別途、skimageで画像をNumpy配列として読み取り、画像の幅と高さを取得しています。

そして、それをRekognitionで取得した相対的な位置と掛け合わせることで、絶対値での座標に変換しています。

import matplotlib.pyplot as plt

from matplotlib import patches

from skimage import io

# matplotlib表示用に画像を配列で読み込み

img_array = io.imread("./family.jpg")

# 画像の高さと横幅を取得

image_h, image_w, _ = img_array.shape

fig = plt.figure(facecolor="w", figsize=(12, 12))

ax = fig.add_subplot(111)

# 元の画像を表示する

ax.imshow(img_array)

for face_detail in response["FaceDetails"]:

# 検出された顔の位置を取得し、座標に変換する

left = face_detail["BoundingBox"]["Left"] * image_w

top = face_detail["BoundingBox"]["Top"] * image_h

width = face_detail["BoundingBox"]["Width"] * image_w

height = face_detail["BoundingBox"]["Height"] * image_h

# 取得した座標の位置に長方形を描写する

patch = patches.Rectangle(

xy=(left, top),

width=width,

height=height,

fill=False,

ec="w",

linewidth=2,

)

ax.add_patch(patch)

# 目、鼻、口の両端に点をプロット

ax.scatter(

[landmark["X"] * image_w for landmark in face_detail["Landmarks"]],

[landmark["Y"] * image_h for landmark in face_detail["Landmarks"]],

c="w",

s=3

)

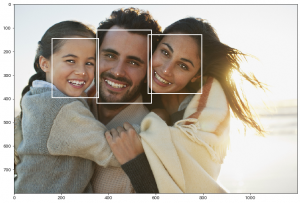

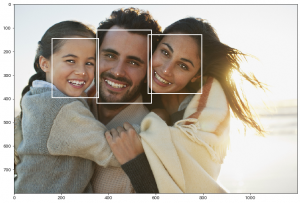

このコードで出力されるのが次の画像です。

3人分の顔が精度良く検出できていることがわかりますね。

さて、detect_faces()ですが、実はもう一つ引数を持っています。

それが、Attributes です。

Attributes=[“DEFAULT”] (こちらがデフォルト)

または、

Attributes=[“ALL”]

と指定します。 []も必須です。

response = client.detect_faces(

Image={'Bytes': img},

Attributes=["ALL"]

)

のように、 [“ALL”]を指定すると、取得できる情報が一気に増えます。

表情(笑顔かどうか)や、メガネやサングラスの有無、髭の有無や口が開いているかどうか、

大まかな年齢の推定なども行ってくれます。

また、目や口の位置情報はより詳細になり、輪郭や眉毛などに関する位置も取得されます。

結果がものすごく大きくなるのでこの記事には載せませんが、ぜひ一度試してみてください。